Facebook斥资1.3亿美元创建「最高法院」,可推翻

如今Facebook已经坐拥20亿用户,这20亿用户就意味着什么样的人和言论都可能出现在平台上。内容审查成了最头疼的问题。

新西兰枪击案直播之后,脸书上的内容监管该咋办?

自2017年8月以来,缅甸安全部队对罗辛亚人发动了「清剿行动」,焚烧了数百个罗辛亚穆斯林村庄,强奸并杀害当地居民,到2018年初,约70多罗辛亚人跨越边境,逃到孟加拉国避难。

当时缅甸的用户利用Facebook Messenger散布暴力和仇恨言论,加剧了对罗辛亚穆斯林的「种族清洗」。

2019年,新西兰大规模枪击事件中,凶手惨无人道地用Facebook做直播。事件发生的24小时以内,平台不得不删除了150万个关于枪击案的视频,还受到了舆论的强烈指责。

在过去几年,Facebook一直面临着各种诸如此类的争议。

小扎对此也是无可奈何。2018年末,他在博客中写道: 「过去两年的经验教训已经表明,没有足够的安全保障措施,人们就会滥用网络工具来干涉选举、散播错误信息,甚至煽动暴力,我学到的最痛苦的教训之一就是,当你想把20亿人连接在一起时,你会看到所有人性的美好和丑陋。」

文中,他还提到了打击边缘内容(暴力、恐怖主义等)的策略。

研究发现,如果不加以控制,人们将会大范围地参与到耸人听闻的网络内容当中,这是自然而然的。「电视新闻中这种消息传播得最广,而且一个多世纪以来一直是小报的主要内容。如果这种内容规模化,它可能会降低公共话语的质量,并导致两极分化。在Facebook的例子中,它还会降低我们的服务质量。」扎克伯格说到。

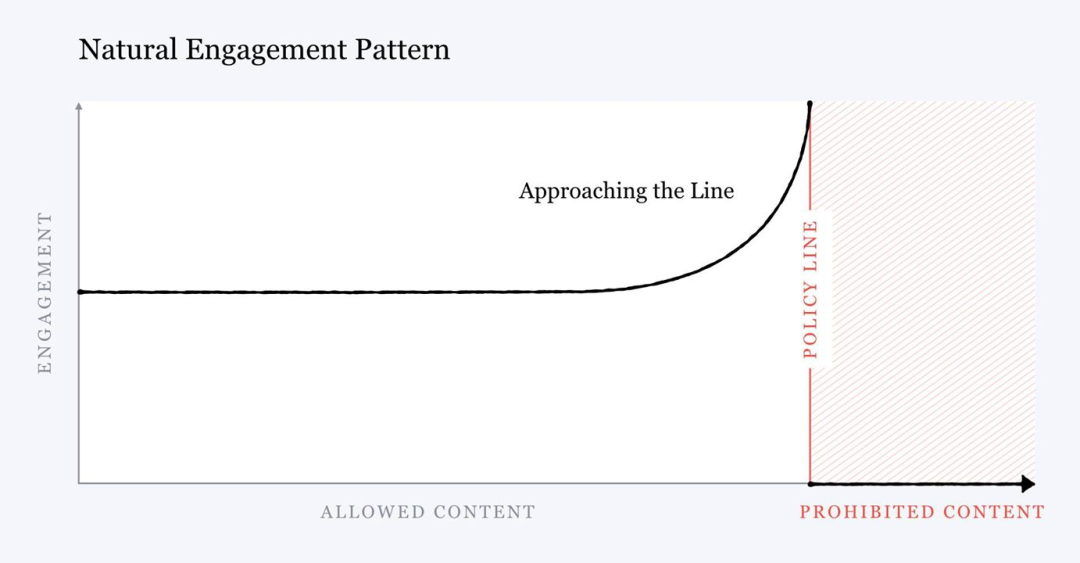

Facebook的研究表明,无论我们划定的内容审核边界线在哪里,当内容越接近这条边界线时,平均会有更多的人参与其中---- 即使事后他们会说,不喜欢这些内容。越知道不好,越想看。

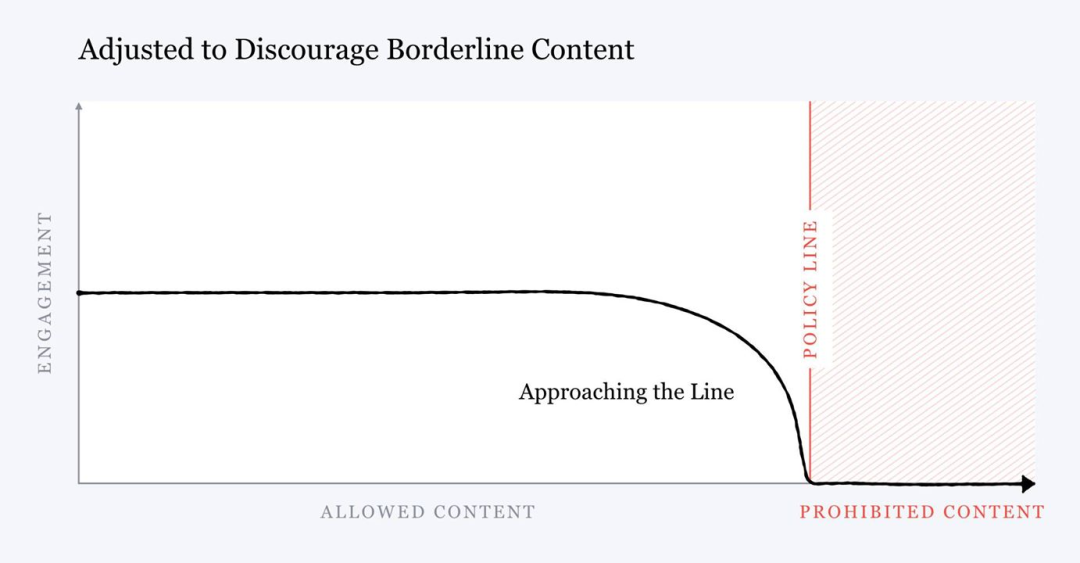

这是一个基本的激励问题,我们可以通过处罚边缘内容来解决这个问题,从而减少相关内容的分发和参与。调整后的分布曲线如下图,随着内容变得更加耸人听闻,内容分发下降,参与度随之下降,人们创造煽动性的内容的动力减弱。

所以识别边缘内容就变得尤为重要。「 我们训练AI系统来检测边缘内容,从而减少相关内容的分发。」

这些边缘内容触犯了Facebook 的社区标准,包括儿童色情等非法图片,仇恨言论、网络骚扰,以及最近关于冠状病毒流行的虚假信息。

当然仅仅有AI检测边缘内容是不够的,需要有更细致的内容审查决策参与其中。

首批20人成员名单,包括丹麦前首相和诺奖得主

2018年底,小扎宣布了一个雄心勃勃的计划: 创建一个独立的内容监督委员会,这个委员会可以推翻 Facebook 的内容管理政策,甚至可以否决小扎的决定。

他们拥有删帖的最终决定权。「如果用户不满意他们的内容被删,可以直接向委员会提出申诉。」扎克伯格说,「如果委员会决定推翻 Facebook 的决定,那么他们拥有最终话语权,我或是Facebook 的任何人不同意都没用」。

这也一定程度上减轻了公司高管面临的舆论压力。公司承诺提供1.3亿美元用于委员会的筹资和运营,并在2020年启动。

就在近日,Facebook 公布了首批监督委员会的成员名单,其中包括前丹麦首相、诺贝尔奖获得者,前卫报主编等,以及一系列关注人权相关问题的专家和律师。 这些委员会成员并非Facebook的员工所以这意味着公司无法解雇他们。

以下是首批20名成员(未来会增加到40个)

1. Tawakkol Karman记者、诺贝尔奖获得者